NeurIPS 2020 pre-proceedings をみるとタイトルに time series を含む論文が…9件もありますね。上から順にメモしていきますか…面倒ですが…。なお、現時点でクリック先で閲覧できるアブストラクトを一通り読んだのみの妄想的な理解であることに留意ください。先に手短にまとめておきます。

- ODE-LSTMs ― 不定期的サンプルに強い ODE-RNNs を改良し長期依存性を学習できるようにした。

- Adversarial Sparse Transformer(AST) ― ジェネレータで疎なアテンションを生成しディスクリミネータで予測性能を高めることで長期予測しても誤差が蓄積しないモデルを実現した。

- Deep Rao-Blackwellised Particle Filters ― 提案分布の factorization と decoder を組み込んだディープなラオ・ブラックウェル化粒子フィルタを提案しスイッチングするシステムを予測できるようにした。

- 自己相関をもつ時系列どうしの因果関係を高感度に発見する手法 ― を提案した。

- NeuralCDE ― ODE モデルの途中経過を後から修正できるようにした。

- temporal saliency rescaling(TSR)― 時系列モデルの変数重要度を上手く出せるようにした。

- STRIPE ― 非定常な幅広い時系列の分布予測を実現した。

- Normalizing Kalman Filters ― ディープニューラルネットを用いた Normalizing Flow 付きのカルマンフィルタで複雑に分布する多変量時系列の分布予測を実現した。

- 自己符号化器を用いた時系列からのストレンジアトラクタの再構築 ― カオティックな時系列から主要な成分を抜き出す自己符号化器を学習した。

さらに目的別に整理してみます。

- 予測:

- 観測が不規則: ODE-LSTMs、NeuralCDE

- 長期予測: AST

- スイッチングするシステムの分布予測: Deep Rao-Blackwellised Particle Filters

- 非定常な幅広い時系列の分布予測: STRIPE

- 複雑に分布する多変量時系列の分布予測: Normalizing Kalman Filters

- 因果推論: 自己相関をもつ時系列どうしの因果関係を高感度に発見する手法

- 予測モデルの解釈: TSR

- 主成分の特定: 自己符号化器を用いた時系列からのストレンジアトラクタの再構築

大多数の目的が予測であることは昨年と変わりません。昨年に引き続き ODE モデルが複数提案されていますが、昨年と違い

再帰 and/or 畳込みのみのモデルがありませんね。そして、予測に分類される論文の半数は昨年なかった(はず)の分布予測です。そして予測に分類されない発表は昨年に比してかなり実践的な興味に寄っているようにみえます。無論、昨年も今年もタイトルを "time series" でフィルタしているので ”sequential” や "recurrent" やその他のワードも確認しなければなりませんが疲れたので今回はこれで…。

「不規則にサンプリングされた時系列からの長期依存性の学習」…興味深いタイトルです。えっと、

- 常微分方程式による連続的な隠れ状態をもつ RNN は不規則にサンプリングされた時系列のモデリングに有利であると(昨年 ODE-RNNs がありましたよね)。

- しかし長期依存性の学習が難しいと。それは RNN の勾配消失/爆発に起因することを示すと。

- なので ODE-LSTMs にすると。

素人考えでは ODE-RNNs が提案されたら一瞬で ODE-LSTMs が提案されそうな気もするんですが、LSTM への移行がそんなに単純ではないのか、LSTM にする意義が非自明なのか、ODE-RNNs 自体がまだ精査される段階であったんでしょうか。いっても翌年に提案されるのは一瞬でしょうか。昨年2つあった ODE 系が今年も2つありますね。

「時系列予測のための敵対的で疎な

トランスフォーマー」でしょうか。「点予測モデルはデータの確率的な性質を捉えない」というのはわかりますが、確率的なモデルも同様だとはどういう意味でしょうか…。また、多くのモデルは長いステップ先の予測をすると誤差が蓄積されるとありますね。AR モデルのようなのを想定されているはずです。それらのような問題を GAN をベースにした

Adversarial Sparse Transformer(AST) で解決すると。ええ…話がいきなりですね…いまの話のいったいどこから GAN が…。…ジェネレータが生成する疎なアテンションは「次のステップを予測するのに重要なのはこれまでのステップのこのステップとこのステップだけだ」みたいな雰囲気なのでしょうか、わかりませんが。ディスクリミネータの役割は、モデルが生成した次ステップと真の次ステップを見分けて「まだ全然見分けられるんだけど?」と叱咤する係なんですかね、妄想ですが。普通は単にモデルの予測値と真の値との誤差を小さくすればよさそうですが、特に自己回帰しながら長期予測する時系列モデルでは中間予測が重要なので特別にこういう工夫を入れてもよさそうです。…これは結構新鮮なア

イデアな感じがしますね。

「時系列予測のためのディープなラオ・ブラックウェル化粒子フィルタ」…粒子フィルタのラオ・ブラックウェル化がわからないので詰んだんですが…検索したら以下が出てきましたね。

「粒子フィルタだが一部の状態については解析的にできるので解析的にやる」というのに「ラオ・ブラックウェル化」という名が付いているんでしょうか…? それで

アブストラクトに入ると、スイッチング

ガウス線形動的システム? これは響き的に以下の図のようなシステムでいいんでしょうか。

現実だとどんなデータがこうなるんでしょうか、コマースサイトのログデータはセール期間中と期間外でモードがスイッチする気はしますが。とりあえずこのようなシステムが生成する時系列をいい感じに学習できるんですね。これは元々ラオ・ブラックウェル化粒子フィルタで扱う問題という認識でいいんでしょうか。スイッチングしたらその先は解析的といった感じがしますし。…あ、ディープ化することで

非線形にも対応できるんですかね。何やら提案分布を factorization するようですが…?

未知の交絡因子がある場合でも自己相関をもつ時系列ど

うしの因果関係を高感度に発見するということでいいんでしょうか。既存手法(FCI and variants?)は感度が低いことを示すと。なので新手法を提案するんですが、この

アブストラクトは既存手法の知識がないと読むのが困難ですね…。以下にコードが公開されているようです。この論文は

モデリングではなく因果関係の検知ですが(広義には

モデリングなんでしょうか)、その検知にも

ニューラルネットを使うということでもなさそうですね?

アブストラクトにもそのようにありませんし

リポジトリの setup.py でもそれらしいライブラリを入れていませんし。

また

常微分方程式ですね。不規則にサンプリングされた時系列の

モデリングに有利だが途中経過が初期条件に縛られてしまい後から修正できないと。なので controlled differential equations なるものを導入して解決するんでしょうか? 提案する

NeuralCDE は観測をまたいだ adjoint-based backpropagation を利用できるのも既存手法と異なるようです。これ、途中経過を後から修正できるから一気に複数時点のデータから

誤差逆伝播できるという話なんでしょうか? わかりませんが。NeuralCDE が他の ODE モデルを包含していることも示されているようですね。あ、controlled differential equations で検索したときに本論文の

GitHub が出てきたので張っておきます。

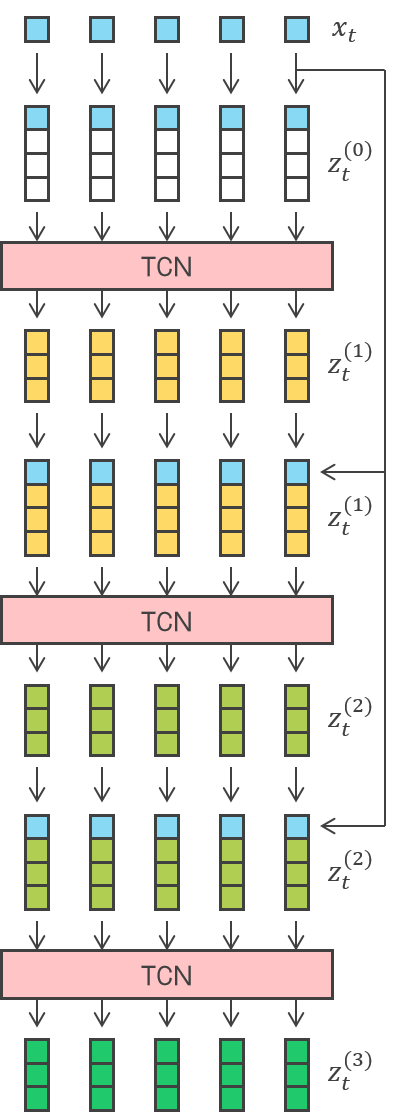

Saliency 法とは何でしょうか…とりあえず入力特徴の重要度を出す手法のようですが、時系列データにはあまり適用されていないようですね。RNN、TCN、transformers などの多様な

アーキテクチャ間で Saliency 法に基づく解釈手法のパフォーマンスを比較するようです? 解釈手法のパフォーマンスとは何でしょうか…? 精度と感度について以下のようにありますが。

- 精度 ― 検知された特徴が重要な信号を発していたか。

- 感度 ― (本当に重要な信号を発していたうち?)検知された特徴の数。

…しかし、これであるネットワーク構造が解釈しやすいとか解釈しにくいとか結論付けられるんでしょうか。Saliency 法がわかっていないからかもしれませんが、手法が悪いかどうかと区別できなさそうですし、どの特徴を重視するかもモデル依存なような…って、基本的には重要な特徴の検知に失敗するんですね? 2ステップの

temporal saliency rescaling(TSR) を用いると改善されるようですが…これはモデルに手を加えなくてもいいんでしょうか。よくわかりません。

非定常な様々な時系列の将来のある時点の分布を予測するのでしょうか。

STRIPE というのがモデル名なのですかね。何の略なのか…STRIPE モデルは DPP(決定的点過程)

カーネルというのを組み込んで用いるのでしょうか。寡聞にして

アブストラクトからどんなモデルの系譜なのかよくわかりません…非定常な時系列をそのまま分布予測しようとする自体が取り組まれてこなかったとかなんでしょうか。

カルマンフィルタを Normalizing Flow で強化したということですが、Normalizing Flow とは…以下の記事を参考にすると、

ガウス分布にしたがう確率変数に

非線形変換を繰り返して複雑な分布を表現するようですが、

ディープ

ニューラルネットを用いているのはこの

非線形変換なんでしょうか。確かに「KF なので大規模な時系列に適応できるし Normalizing Flow を用いるので分布が複雑でもいい」となりそうな気もしますが。

「時系列からの

ストレンジアトラクタの再構築(ディープ

ニューラルネットを用いた)」でしょうか。

ストレンジアトラクタとは?

ローレンツアト

ラクタを描いたことはありますが、あれは

ストレンジアトラクタの一種なんですね? 奇妙であればよいと。まあそれで、問題設定としては、普通はたくさんの変数を観測して主要な成分を突き止めるが、観測が少ないときに隠れた支配的な軸を見つけ出すことをしたいんですかね。入力空間を自己符号化器で理想の空間に埋め込むのでしょうか。損失関数が気になりますね。これが novel とありますが。しかし、これって少ない次元の観測から欠けた次元を復元できるといった話なんでしょうか。普通はできない気がしますが、カオスに動き回るのでその動きさえきちんと捉えればできるということなんでしょうか。わかりませんが。

アブストラクト内にあるように、色々なデータについて主要な成分を取り出すのに応用できそうですね。

の実現値

の同時分布は以下になりました。この分布は「最初に出てくる

はどんな分布だろう」「

を観測した上で次の

はどんな分布だろう」 と積み上げていけば導くことができます。

はどんな多変量正規分布にしたがうだろうか?」というアプローチで同じ同時分布を導きました。

が所与」という考えやすい場合で実際に最尤推定値を求めますが、前回は流してしまったので改めて追ってみます。

が所与なら上の同時分布は以下のように化けますね。

が所与の場合)

が所与の定常ガウシアン AR(1) 過程の最尤推定値

点

はどんな多変量正規分布にしたがうだろうか?」を考えた上で、

を観測した上で次の

はどんな分布だろう」を積み上げていっています。

は AR(1) のときと一緒だよね。期待値と分散は AR(2) のそれにしなければならないけど。あと、直近の

点

を観測した下での

の分布

も AR(1) のときと同じ要領だね。

というパラメータを与えて用いるんですね。どのように決定すればいいんでしょうか。

を与えなければ勝手に決めてくれるって。

を出す式が特定できた下で、それを最大化する

を如何に求めるかという話が残っていますが(

が所与の場合の最小2乗法はやりましたが)、5.7 節は数値的に最大化する方法ですね。紹介されているのは以下でしょうか。