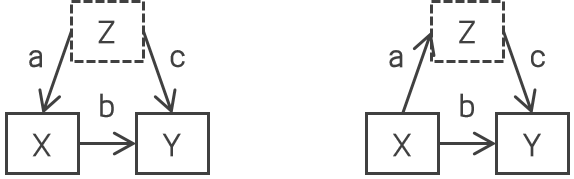

統計的因果探索手法の LiNGAM で実際に因果グラフを推測するアプローチの一つに、「正しくない因果的順序で回帰すると(原因の変数を結果の変数で回帰すると)、説明変数と残差が独立にならない ⭐」ことを利用して因果的順序を特定するものがありますが、⭐ を保証する

ダルモア・スキットビッチ定理の証明が気になったのでウェブ上で拾った参考文献の自分の訳をメモします。解釈の誤りは自分に帰属します。定理1と定理2の証明はありません(参考文献にも)。お気付きの点がありましたらコメントでご指摘いただけますと幸いです。

なお、

ダルモア・スキットビッチ定理は以下の定理3で、「確率変数

がどちらも、非

ガウス分布にしたがう

の1次の項を含んでいる(係数

がどちらもゼロでない)ならば、

と

は独立にならない」といっても同じです。LiNGAM の文脈では、

を結果変数の誤差項、

を結果変数、

を結果変数で原因変数を回帰したときの残差とすれば、

も

も非ゼロであり、結果変数と誤差項が独立になりません。

を何回でも

微分可能な関数とし、任意の

について以下のようにかけるとする。

ただし、

はゼロでない定数であり以下を満たす。

このとき

は高々

次の

多項式である。

式において、以下のように、

は一定に保ちつつ

と

を変化させることを考える。

(上の3番目の式が表す直線

上の原点以外から

を選べばよい。)ここで、

は

では

にならない(∵

)。

と

を変化させた後の

式から変化させる前の

を引くと以下のようになる。

は

を意味する。同様の変化を

の項だけになるまで(

回目まで)繰り返すと以下のようになる。

回目には

を固定して

だけ変化させる。

回目には

を固定して

だけ変化させる。

ここで、各回の変化

は好きな値にとれるが、どのような値にとっても結局

になる。これは

の

次の

導関数が

ということに他ならない。したがって、

は高々

次の

多項式である。

についても同様。

定理1( Lévy-Cramer )

を互いに独立な確率変数とし、

とする。このときもし

が

ガウス分布にしたがうならば、

と

も

ガウス分布にしたがう。

定理2( Marcinkiewics-Dugué )

(

は

多項式 )の形の特性関数をもつ確率変数は、定数確率変数か

ガウス分布にしたがう確率変数だけである(したがって

多項式の次数は2以下である)。

定理3( Darmois-Skitovic )

を互いに独立な確率変数とし、

を以下のように定義する。

このときもし

と

が独立ならば、

であるようなすべての

で

は

ガウス分布にしたがう。

定理3の証明

としても一般性を失わない(∵ もし

になる

があれば

という新しい確率変数にマージすればよい; もしこのマージした確率変数が

ガウス分布にしたがうならば

定理1よりマージする前の確率変数も

ガウス分布にしたがう)。

いま

の特性関数は以下のようになる。

![\Phi_{Y_1, Y_2}(\omega_1, \omega_2) = E \bigl[e^{j(\omega_1 Y_1 + \omega_2 Y_2)} \bigr] = E \bigl[e^{j \sum_{i=1}^N (\omega_1 a_i + \omega_2 b_i) X_i} \bigr] = \prod_{i=1}^N \Phi_{X_i} (a_i \omega_1 + b_i \omega_2)](https://chart.apis.google.com/chart?cht=tx&chl=%20%5CPhi_%7BY_1%2C%20Y_2%7D%28%5Comega_1%2C%20%5Comega_2%29%20%3D%20E%20%5Cbigl%5Be%5E%7Bj%28%5Comega_1%20Y_1%20%2B%20%5Comega_2%20Y_2%29%7D%20%5Cbigr%5D%20%3D%20E%20%5Cbigl%5Be%5E%7Bj%20%5Csum_%7Bi%3D1%7D%5EN%20%28%5Comega_1%20a_i%20%2B%20%5Comega_2%20b_i%29%20X_i%7D%20%5Cbigr%5D%20%3D%20%5Cprod_%7Bi%3D1%7D%5EN%20%5CPhi_%7BX_i%7D%20%28a_i%20%5Comega_1%20%2B%20b_i%20%5Comega_2%29)

他方、

が独立であることから、

の特性関数は以下のようにならなければならない。

したがって、

両辺の対数をとって(

は第2キュムラント母関数)、

ここで、左辺の

であるような

については右辺に移項する。それで

補題1を適用すると、

であるような

で

は

多項式であることがわかる。よって

定理2より

は

ガウス分布にしたがう(分散がゼロでないと仮定しないならば定数確率変数でもありうると思う)。